谷歌爬取url的一直出错显示,无法获取Robots.txt,我根据Gemini、gpt、grok给出的办法依次排查了网站的出入站规则、服务器的防火墙、宝塔的防火墙,都没有发现问题,最终认定是服务器网络的原因,毕竟谷歌服务器是在国外,于是尝试使用cdn加速试试。正好前几天看到阿里云推荐的有边缘安全加速 ESA因为有一个月的基础版使用便尝试使用,开启之后感觉好像没什么变化,直到后来才知道我没配置正确......

不过正确配置之后确实可以被谷歌爬取到了,如果有类似的不被谷歌爬取可以尝试一下,接下来就是这一路的旅程。

初次意外

大约是在25年的12月左右,我发现我的谷歌不收录了,我注意到我申请编制时候显示Robots文件不可用,我和奇怪我明明可以访问的,同时我的Robots文件也没有禁止什么特殊的链接,于是经过排查注意到那时候我的网站爬取的是带有www的域名,我已经将这个域名重定向到了不带www的那个,我就怀疑是这时候出现了问题,然后便更换了域名地址果然好了!!!

再次意外

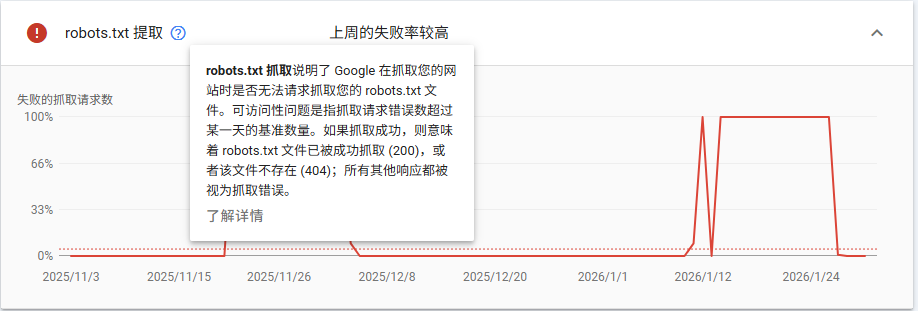

过了有半个月我进去站长平台的时候发现再次显示Robots文件不可用,我就很纳闷明明之前可以的为什么过了一段时候后又不行了,经过简单的排查在谷歌站长的设置-抓取统计信息-托管状态中Robots文件的失败率达到了惊人的100%,那时候我思考可能还是网络的问题说不定什么时候就好了。

初次尝试

最终还是按耐不住折腾的心,在网上搜索解决办法但是好像没有类似的文章去解答,我问Ai给出的也都是排查服务器和宝塔的设置,同时我在确认都没有问题后Ai给我说可能是网络的原因,这时候我也没在意我想到了去看日志,这样就知道报错在哪了,我做了一个关键实验:我一边盯着宝塔的实时日志,一边在 Google 站长后台点击抓取。结果很扎心:浏览器访问时日志刷刷跳动,而 Google 抓取时,日志竟然一条都没有。这证明了请求在到达我的服务器之前,就在茫茫公网中‘丢了’。 这种‘还没进门就失联’的情况,单纯调服务器配置是没用的。这时候我才想起Ai说的网络的问题,于是便去接着询问并说明了状况,之后推荐我使用cdn试试。

终于解决了

我听从了Ai的建议,正好前几天看到宝塔公众号的文章可以免费试用阿里云的ESA加速,便去申请了一个,第一次使用只用一个月,后面可以通过发文章宣传进而获得全额抵扣券,看到这里估计有朋友就要问了:那是写这个文章是不是就是来打广告的。唉,打广告先不说,但是这个真的是解决了我们提到的那个问题,由此我们也反推出关于谷歌爬虫不爬取的时候那大概率就是网络的原因了,弄一个cdn或许就解决了。

OK文章到这里就结束了,感谢你看到这里其实看第一段就好了,后面就是我这件事的大概经过,这次经历让我意识到,很多时候我们死磕服务器配置,其实是找错了方向。解决问题的关键往往在你看不到的链路里。至于我是如何配置 ESA 成功回源、并让 Googlebot 重新‘爱上’我的博客的,下一篇咱们细聊。(为了那张全额抵扣券)